Runway Gen2: il ChatGPT per i video

Tra le moltissime startup che affollano il settore della generative AI per i Video RunwayML è quella che ha sfornato il motore grafico generativo più promettente.

Runway ML

Nel vasto panorama tecnologico, l'emergenza di strumenti innovativi ha cambiato il nostro modo di interagire e comprendere i contenuti digitali. Allo stesso modo in cui ChatGPT ha stabilito nuovi standard nella comprensione e produzione di testi, trasformando la comunicazione e il modo in cui assimiliamo informazioni, Runway Gen-2 si sta facendo strada come la figura di punta nel mondo dei contenuti visivi, promettendo una rivoluzione nel modo in cui percepiamo e creiamo contenuti video.

Runway è molto più di un semplice software: rappresenta un passo avanti nell'era digitale. Ha il potere di prendere le semplici parole e tradurle in video ad alta risoluzione, una caratteristica che un tempo avremmo potuto trovare solo nei romanzi di fantascienza. Immagina di poter scrivere "una ripresa aerea di un paesaggio montano" e vedere questa descrizione prendere vita davanti ai tuoi occhi. È la magia dell'intelligenza artificiale al servizio della creatività umana.

Dalla Gen-1 alla Gen-2: l'Evoluzione

Il progresso tra Gen-1 e Gen-2 non è solo una questione di capacità avanzate, ma rappresenta una vera e propria rivoluzione nel modo in cui vediamo la produzione di contenuti. È simile al contrasto tra i primi tentativi di modelli di lingua e le capacità quasi umane di ChatGPT. Se ChatGPT ha permesso all'IA di comunicare in modo efficace e coeso, Gen-2 le ha permesso di visualizzare e creare, trasformando parole in immagini in movimento.

Come funzionano i modelli Gen-1 e Gen-2?

Gen-1 aveva già aperto nuove porte, permettendo la rielaborazione di video con nuove textures, colori e stili basati su input testuali o visivi. Ma Gen-2 ha alzato l'asticella. Oltre a rielaborare, ora può creare. Basandosi esclusivamente su descrizioni testuali, è possibile dar vita a scenari, storie e visioni che prima esistevano solo nella nostra immaginazione.

Implicazioni Future e Potenziale

Un panorama affollato per la generazione testo-video

Mentre il campo della generazione testo-video è affollato con titani come Google e Meta (basti pensare a DragGAN o a Make a Video), Runway AI si distingue non solo per la sua innovazione, ma anche per la sua dedizione a rendere il processo creativo accessibile. La piattaforma offre non solo la generazione di video, ma anche una vasta gamma di strumenti di editing, assicurando che l'arte del video editing e della produzione sia alla portata di tutti, dai professionisti agli appassionati.

Le possibilità per il cinema: uno dei primi pionieri è italiano

Con la sua capacità attuale di produrre video basati su testo, l'industria cinematografica e di produzione video si trova all’inizio di un cambiamento radicale. Nonostante ci siano ancora sfide da superare, in particolare in termini di realismo, l'accelerazione tecnologica suggerisce che potremmo presto vedere l'IA produrre contenuti che sfidano ogni distinguo con la realtà.

Il regista italiano Edoardo De Angelis, che con il suo film con protagonista Pierfrancesco Favino aprirà la mostra del cinema a Venezia, è stato un pioniere nell’uso dell’intelligenza Artificiale nel cinema.

Il film "Comandante" è ambientato durante la Seconda Guerra Mondiale su un sottomarino e ha sfruttato in modo intensivo la tecnologia della produzione virtuale. Uno degli obiettivi principali della produzione virtuale era ottenere un'anticipazione di ciò che sarebbe stato nel fotogramma finale.

La previsualizzazione, o "previs", si è rivelata particolarmente efficace per individuare momenti narrativi chiave. Ad esempio, inizialmente il regista aveva l'idea che la telecamera dovesse sentirsi come un membro dell'equipaggio sul sottomarino. Tuttavia, considerando le dimensioni ridotte di un vero sottomarino, è diventato evidente che alcuni scatti avrebbero dovuto essere effettuati dall'esterno dell'imbarcazione usando la Technocrane, ovvero una gru per cinepresa telescopica.

Un altro aspetto rivoluzionario del film è stato l'uso della composizione in tempo reale sul set e degli ambienti virtuali pre-realizzati. Questi fornivano modelli accurati dei fotogrammi finali direttamente sul monitor del regista. Anche se la produzione era ancora in corso in Italia, questa caratteristica ha permesso di ottenere dei rough cut molto avanzati. In pratica, anche se la produzione non era ancora terminata, il team aveva già una chiara visione di come sarebbe apparso il film.

Infine, l'approccio alla produzione virtuale ha permesso di avere un'idea chiara del film molto prima della post-produzione tradizionale. Mentre in passato i registi dovevano attendere la post-produzione per avere un'idea di come sarebbe stato il film, con l'uso della produzione virtuale, Edoardo de Angelis aveva già una chiara visione del film molto prima della sua conclusione.

Una cosa è chiara: la convergenza tra creatività umana e capacità dell'IA è solo all'inizio.

Trick per generare video fantastici

Se volete tirare fuori il meglio dai rispettivi modelli potresti generare una immagine da Midjourney e poi animarla e trasformarla in video con RunwayML e se ti servisse la generazione dell’audio come ad esempio la voce di un personaggio potresti usare Eleven Labs, se invece ti servisse una musica prova beatoven.ai se vuoi vedere un esempio ecco il video che ho creato per mostrare alla mia ragazza le potenzialità di queste soluzioni, ho preso un film a lei caro come Harry Potter e ho chiesto a ChatGPT di creare un testo in cui Harry parlava di come ha superato tutti i traumi a cui è stato sottoposto durante i suoi anni giovanili, successivamente ho generato una immagine di Harry Potter (ovviamente con il volto di Daniel Radcliffe) e poi le ho dato voce con Eleven Labs e quindi ho animato l’immagine tramite un altro utile strumento D-ID. Un tocco ulteriore spesso può essere dato con Capcut o AudioJungle per la musica.

Per vedere il risultato finale date una occhiata al video pubblicato nella sua pagina e dato che ci siete lasciatele un follow.

Kilobyte: il meglio di link, tool e news sull’Innovazione ed il Digitale

Le notizie più interessanti di questa settimana

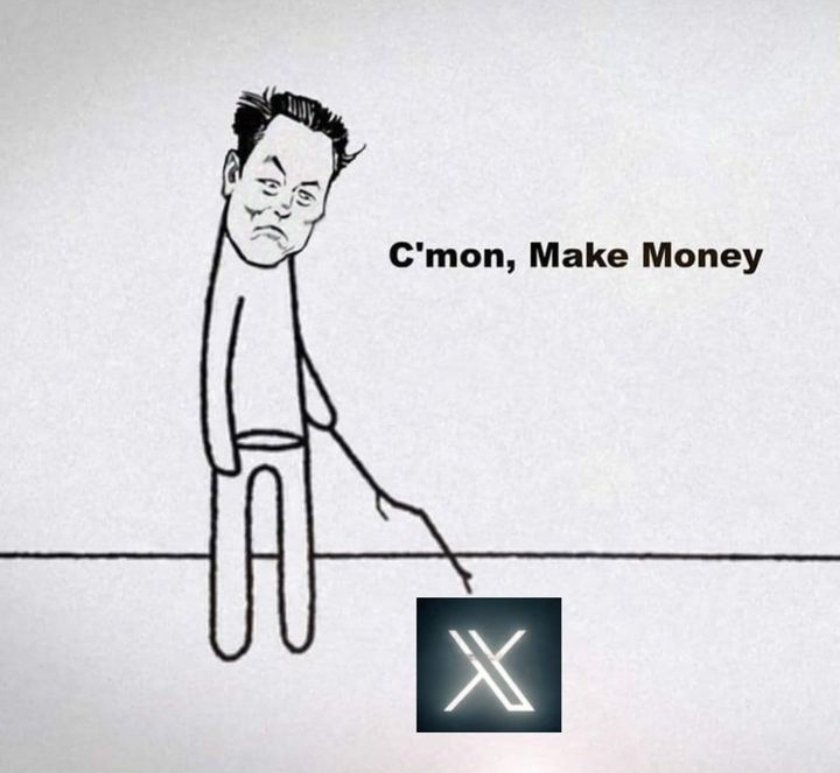

Twitter cambia nome in X

ChatGPT sta arrivando su Android: possibile prenotarne il download (Play Store)

OpenAI chiude il tool per rilevare i testi scritti da AI dichiarandone l’inefficacia (Decrypt)

Arriva Med-Palm il modello di linguaggio pensato per il settore medico (Google)

Tool interessanti

Link interessanti

Gartner ha pubblicato il suo Hype Cycle aggiornato al 2023 per il settore dell’AI, ne avevamo parlato in una delle scorse newsletter.

Un primo sguardo al generatore di immagini segreto di OpenAI

Se sai cos'è un manager AI, Netflix potrebbe assumerti per 900.000 dollari

Cartoline dal futuro, uomini e AI: sicuri che siamo noi quelli a dover temere?

Prompt della settimana

Suggeriscimi tre idee di prodotti/servizi di nicchia all'interno di [settore/azienda] e le istruzioni su come utilizzarli per ottenere un maggiore controllo su quella nuova nicchia e aumentare il valore del brand.

Azienda = [Inserire qui]

Digital Innovation Meme

Al prossimo numero, nel frattempo scopri cosa puoi fare:

Ci sentiamo presto la newsletter ha cadenza quindicinale, nel frattempo puoi: