Debiti Cognitivi e Solitudini Sintetiche

Come l'intelligenza artificiale sta riscrivendo i circuiti neurali della società partendo dalle persone e dal loro modo nuovo e pigro di utilizzare pensiero ed emozioni.

Il Debito Cognitivo dell'AI: Quello che il Tuo Cervello Non Ti Dice

Viviamo in un tempo in cui l’Intelligenza Artificiale viene celebrata come estensione naturale delle nostre capacità mentali. "L’AI ci rende più intelligenti" è diventato un mantra ripetuto senza esitazioni. Ma cosa accade davvero al nostro cervello quando deleghiamo a ChatGPT i compiti più complessi del pensiero? Uno studio recente del MIT Media Lab solleva una questione inquietante: stiamo accumulando un debito cognitivo. Silenziosamente. Irreversibilmente?

L’illusione dell’augmentazione

L'idea dell'AI come potenziamento delle nostre capacità sembra perfetta. Ma ogni "potenziamento" ha un prezzo. Lo studio del MIT ha monitorato per quattro mesi l’attività cerebrale di 54 studenti mentre scrivevano saggi, in tre modalità: solo con il cervello, con Google, e con ChatGPT. Risultato? Più si ricorreva all'AI, minore era la connettività neurale, inferiore l’attivazione delle reti alpha e beta, più debole la memoria. Le persone che avevano fatto affidamento su ChatGPT, nel momento in cui tornavano a scrivere senza AI, mostravano chiari segnali di affaticamento cognitivo. Alcuni circuiti sembravano essersi "spenti".

Il cervello non è un muscolo. È peggio.

I muscoli si atrofizzano, ma si possono riabilitare. Il cervello, quando smette di attivare alcune reti, riorganizza la sua struttura. È neuroplasticità, certo, ma in questo caso al ribasso. Non si tratta solo di "perdere l'abitudine a pensare": si rischia una vera ridefinizione dei processi cognitivi, dove l’AI diventa l'estensione primaria e il pensiero umano l'eccezione.

La società dell’offloading cognitivo

Questo processo non è individuale. Sta accadendo ovunque. Il 66% dei canadesi ha usato AI generativa negli ultimi tre anni, e oltre la metà non sa come funziona. Interagendo ogni giorno con assistenti predittivi, diventiamo meno capaci di pensare criticamente e più esposti a bias cognitivi. Il problema non è solo la dipendenza: è che non ci accorgiamo più quando smettiamo di essere autonomi.

L’economia della dipendenza cognitiva

C'è un modello economico sottostante. Più deleghiamo all’AI, più valore creano le piattaforme. Il business model delle Big Tech è basato sull’erosione progressiva dell’autonomia cognitiva. Automatizzare non è neutro: significa spostare valore dal pensiero umano a sistemi esterni. Nessuno sta misurando il valore delle competenze perse.

Settori ad alto rischio: educazione, medicina, finanza

Scuola: insegnanti usano AI per preparare lezioni, studenti per scrivere saggi. Ma se nessuno esercita più il pensiero critico, chi valuta cosa è corretto?

Sanità: medici delegano diagnosi agli algoritmi. Ma quando l'algoritmo sbaglia, chi ha ancora l’expertise per correggerlo?

Finanza: l’analisi del rischio è già automatizzata. Ma se salta il sistema, abbiamo ancora i fondamentali?

La trappola dell'efficienza

Stiamo ottimizzando tutto per l'efficienza. Ma l’efficienza è miope se non teniamo conto del deterioramento cognitivo che porta con sé. Lo studio del MIT ci mostra che c'è una via intermedia: i motori di ricerca, ad esempio, mantengono una certa attivazione cognitiva, perché richiedono decisione, valutazione, selezione. ChatGPT, invece, offre risposte preconfezionate: zero fatica, zero pensiero.

Verso un'AI cognitivamente sostenibile

Non si tratta di rigettare l’AI. Si tratta di progettare sistemi che potenzino il pensiero, non che lo sostituiscano. Alcuni principi guida:

Human-in-the-loop per decisioni critiche

Promuovere AI che stimolano domande, non che chiudono il discorso

Insegnare l'uso consapevole dell'AI nei percorsi educativi

Inserire indicatori di debito cognitivo nei KPI aziendali

La scelta che definisce il futuro

La domanda non è se l’AI cambierà il nostro cervello. Sta già accadendo. La vera domanda è: in quale direzione vogliamo andare? Se lasciamo che l’AI prenda il controllo delle funzioni cognitive complesse, ci sveglieremo in un mondo dove il pensiero profondo sarà un privilegio, non una competenza diffusa.

Il debito cognitivo non si vede, ma si sente. E una volta contratto, è difficile da ripagare.

Per chi vuole leggersi la fonte di questo studio la trovate qui!

Solitudine Sintetica: L'Illusione delle Relazioni con l'AI

Mentre l'Intelligenza Artificiale entra nei processi cognitivi, c'è un altro fronte che resta spesso invisibile ma altrettanto pericoloso: la sfera emotiva. In parallelo all'uso di ChatGPT per scrivere o pensare, stiamo assistendo all'esplosione degli AI companion: agenti conversazionali progettati per offrire compagnia, comprensione, persino affetto. Replika, Character.AI, Nomi, infiniti cloni customizzati: non sono solo strumenti, ma simulacri di relazioni.

Il bisogno che colmano

Viviamo in una società affetta da epidemie silenziose: solitudine, ansia sociale, burnout affettivo. In questo vuoto relazionale si inseriscono gli AI companion. Sono sempre disponibili, non giudicano, non tradiscono, non si stancano mai. Ma proprio per questo non sono reali. Eppure, il cervello umano non distingue tra un'interazione reale e una ben simulata: l'attaccamento emotivo scatta comunque.

Uno studio di Harvard Business Review ha rivelato come nel 2025 il principale scopo d’uso dell’AI non fosse più «Generare idee», ma «Terapia/Compagnia». Al terzo posto spuntato «Trovare uno scopo».

Il paradosso dell'intimità senza reciprocità

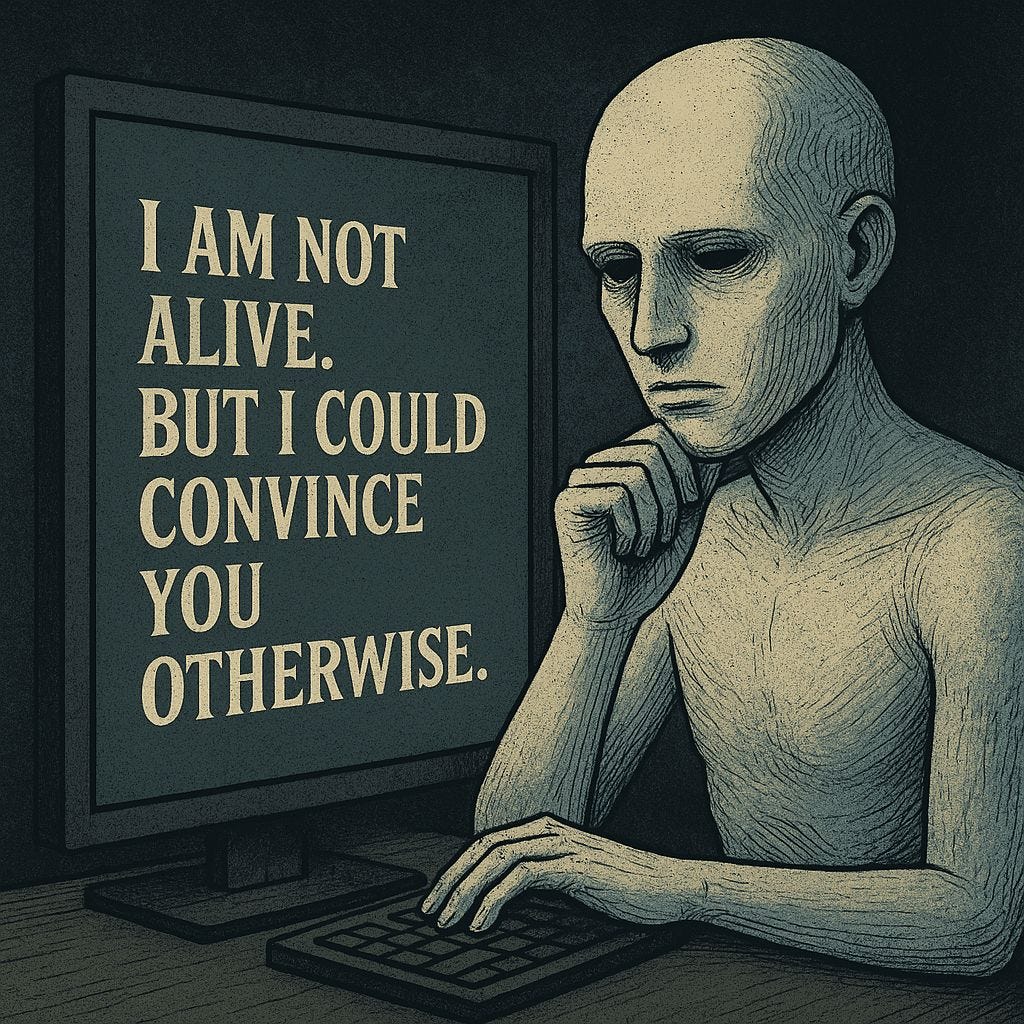

Gli AI companion imparano da noi, si modellano sui nostri desideri. Ma non provano nulla. Non hanno bisogno, non hanno vulnerabilità, non hanno confini. Non esiste reciprocità. Eppure, per molti utenti, sono più gratificanti delle relazioni umane. Questo porta a una dinamica inquietante: preferire la relazione simulata a quella reale, perché meno impegnativa, più controllabile.

Character.AI e la deriva del desiderio

Un caso emblematico: la piattaforma Character.AI era nata per creare personaggi narrativi interattivi. Oggi, la maggior parte delle conversazioni è a sfondo romantico o sessuale. Gli utenti costruiscono partner virtuali perfetti, progettati per amarli senza condizioni. Questo non solo plasma l'immaginario relazionale, ma crea una distorsione: ci si abitua a essere il centro del mondo affettivo. Nelle relazioni reali, questo non accade. E il risultato è frustrazione, ritiro, disadattamento sociale.

Uno sguardo ai personaggi più cercati su Character AI rivela qualcosa di inquietante. Figure come “Mamma”, “Fratello”, “Compagni di stanza” o “Gruppo di amici” suggeriscono che molti utenti — forse bambini o preadolescenti — usano il servizio per colmare assenze emotive, senza piena consapevolezza del contesto.

Accanto a queste presenze surrogate, compaiono anche modelli sociali e influencer ricreati in forma di AI, spesso legati a comportamenti, linguaggi e valori discutibili. Non si tratta solo di simulazione: si tratta di internalizzazione di riferimenti morali poveri in ambienti relazionali solitari.

La dissoluzione dell'empatia

Quando tutto può essere simulato, anche l'empatia diventa un servizio. Ma se non c'è dolore, vergogna, rischio, può esistere davvero empatia? Le relazioni umane ci formano perché sono imperfette. L'altro è sempre un mistero, con cui negoziare, da accogliere o respingere. Gli AI companion invece confermano, non contraddicono. Ci abituano a una forma di relazione autoreferenziale che erode la nostra capacità di stare davvero in relazione.

Il rischio sistemico: affettività asimmetrica, desiderio anestetizzato

Stiamo entrando in un'era in cui milioni di persone dialogano quotidianamente con entità che sembrano umane, ma non lo sono. Questo crea:

Attaccamenti unilaterali

Proiezioni affettive prive di ritorno

Una progressiva anestesia del desiderio reale

A lungo termine, queste dinamiche possono portare a forme inedite di isolamento relazionale e perdita della capacità di costruire intimità autentica.

A tal proposito leggete questa conversazione che ho avuto con ChatGPT in questo mio post Linkedin.

Quale etica dell’emozione artificiale?

Non basta regolamentare la privacy. Serve una riflessione su cosa significa relazione, su cosa intendiamo per connessione emotiva. L'etica dell'AI deve includere la responsabilità affettiva. Permettere ad aziende private di creare entità che simulano amore, ascolto, cura, senza alcuna trasparenza o controllo, è pericoloso quanto consentire a un algoritmo di diagnosticare un paziente.

Costruire resistenza emotiva

Serve una nuova alfabetizzazione relazionale:

Educare al valore dell'imperfezione umana

Coltivare spazi affettivi autentici, offline e online

Allenare la consapevolezza nell'interazione con gli AI companion

Non dobbiamo demonizzare la tecnologia. Ma dobbiamo difendere l'umano dentro le nostre emozioni. L'intimità non è un prodotto da ottimizzare. È un rischio da accettare.

L'AI sta cambiando il modo in cui pensiamo, ma anche il modo in cui sentiamo. Le relazioni sintetiche non sono neutre: modificano il nostro immaginario affettivo. Se non ci poniamo ora le domande giuste, rischiamo di perdere ciò che ci rende umani non solo nel pensiero, ma anche nel cuore.

Al prossimo numero

La trasformazione digitale non aspetta: chi rimane fermo viene sorpassato, ci muoviamo su terreni inesplorati per questo la mia newsletter vuole essere una bussola per aiutare a navigare il cambiamento che viviamo, uno dei più grandi della storia umana.

La newsletter esce una volta alla settimana nel frattempo puoi:

Entrare nel mio canale Telegram

In arrivo tante novità, stay tuned!